AI-Bilder für Animationen

Kunde

Direktion für Entwicklung und Zusammenarbeit DEZA DEZA

Produktion

Geschichte DEZA, Hynek Bures

Regie Hynek Bures

Grafiken & Animationen Ehud Graf

Stimme Fernando Tiberini

Musik Léa Célestine Bernasconi

Textkorrektur Sally Lowick

Sprachen Englisch, Spanisch mit Untertiteln

2023/4

2023 war das Jahr der KI! So heißt es zumindest... Natürlich wollten Ehud, der Grafikdesigner, und ich diese neuen Möglichkeiten erkunden: Wie können wir dieses neue Werkzeug für unsere Kreationen nutzen? Bei der Arbeit an zwei Animationen für die DEZA bekamen wir die Gelegenheit, uns mit der Text-Bild-Erzeugung zu beschäftigen. Als wir mit der Produktion begannen, war ein vollständiger Text-zu-Bewegung-Bild-Workflow nicht möglich. Daher konzentrierten wir uns auf die Generierung von KI-Bildern, die Ehud für die Animationen verwendete. Ich habe wirklich viel von Ehud gelernt, der Stunden damit verbrachte, die Prompts zu perfektionieren. Lassen Sie mich hier unseren Arbeitsablauf beschreiben. Bitte bedenken Sie, dass sich diese Anwendungen fast täglich weiterentwickeln. Was bei dieser Produktion die Realität war, wird in Zukunft vielleicht nicht mehr zutreffen:

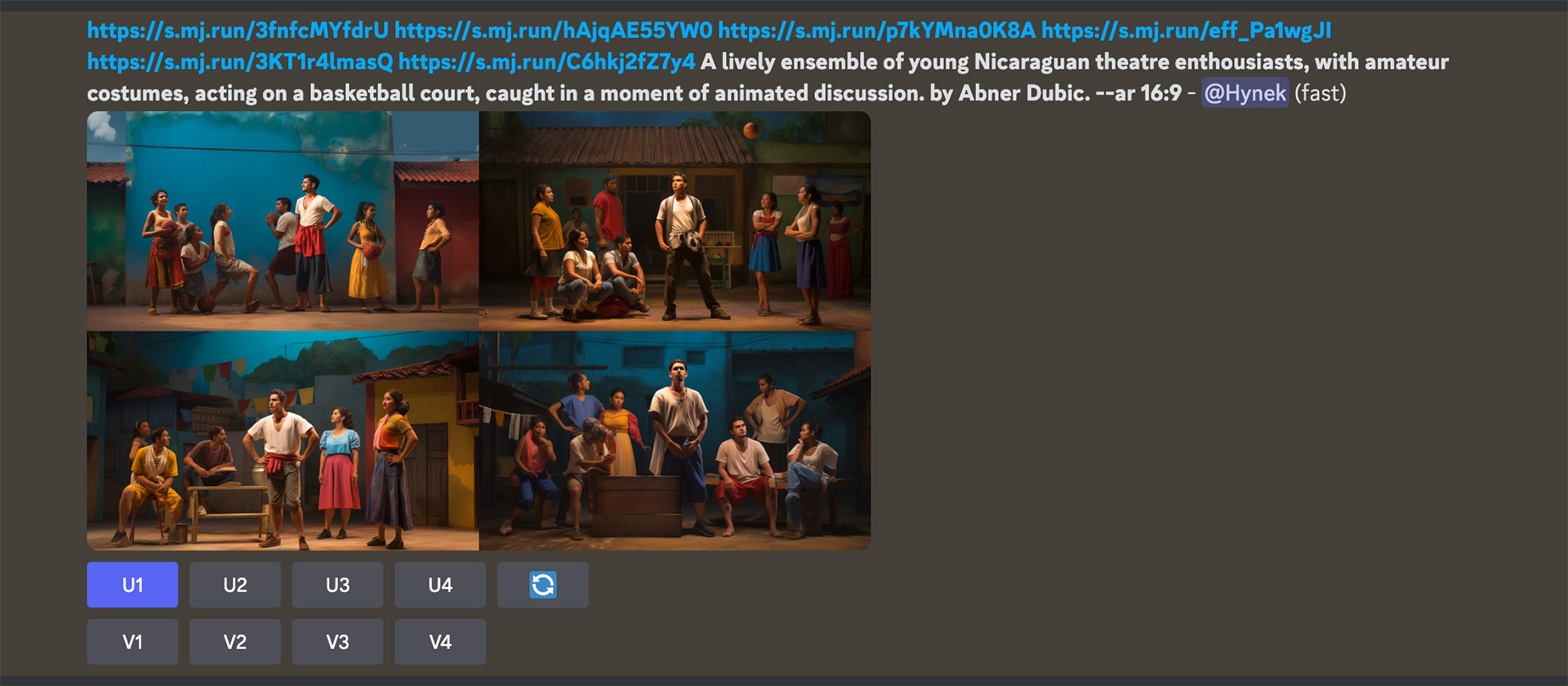

- Wir haben Midjourney (verbunden mit der Discord-Anwendung) für unsere Bilderstellung verwendet. Der Vorteil dieser Anwendung ist, dass man das Bildseitenverhältnis selbst bestimmen kann; in unserem Fall 16:9.

- Unsere Geschichte spielt in Lateinamerika. So haben wir uns dann für den Bildstil entschieden. Wir recherchierten populäre Künstler aus Lateinamerika. Der Schlüssel zu einem konsistenten Bildstil liegt darin, der KI eine klare Vorstellung davon zu geben, was Sie wollen. Die Maschine weicht immer wieder von Ihrem Stil ab. Sie müssen sie immer wieder daran erinnern, was Sie wollen. Einige unserer Aufforderungen enthielten bis zu 7 Bildlinks, um die Maschine auf Kurs zu halten.

- Die Anzahl der erzeugten Bilder im Vergleich zu dem, was in die Animation aufgenommen wurde, muss etwa 20:1 betragen! Sehr oft erzeugte die Maschine das richtige Bild, aber die Gesichter stimmten nicht oder waren einfach nicht so, wie wir sie haben wollten. Man lässt die Maschine ein paar weitere Variationen erzeugen, bis alles im Bild stimmt.

- Manchmal reagierte Midjourney einfach nicht so auf unsere Eingabeaufforderungen, wie wir es wollten. Umgehungen waren notwendig: Wir baten ChatGPT, unsere Prompts umzuschreiben und kopierten/kopierten diese in Discord, oder...

- Der Hintergrund war nicht das, was wir wollten. In einigen Fällen bestand die Lösung darin, das Bild in Photoshop zu öffnen und den Effekt der Hintergrunderzeugung von Adobe zu verwenden.

Hier ein Beispiel für eine Eingabeaufforderung. Beachten Sie die vielen Bildverknüpfungen am Anfang des Prompts:

Unsere Schlussfolgerungen

Text-zu-Bild-Generatoren geben uns die Möglichkeit, mit Bildstilen zu arbeiten, deren Erstellung sonst sehr teuer wäre. So können wir ein Bild im Video relativ schnell ändern, ohne wieder an die Illustrationstafel gehen zu müssen. Aber es ist nicht so, dass wir viel Zeit gespart hätten. Das Erstellen, Anpassen der Prompts und Bereinigen der Bilder ist nach wie vor arbeitsintensiv.

Wir freuen uns auf jeden Fall auf die Text-zu-Bewegtbild-Anwendungen, die sich rasch entwickeln. Wir haben keine Angst, dass sie uns die Arbeit wegnehmen werden, zumindest nicht so schnell. Im Moment brauchen alle diese Anwendungen noch den menschlichen Faktor, um ein Produkt zu schaffen, das den Bedürfnissen des Kunden entspricht.

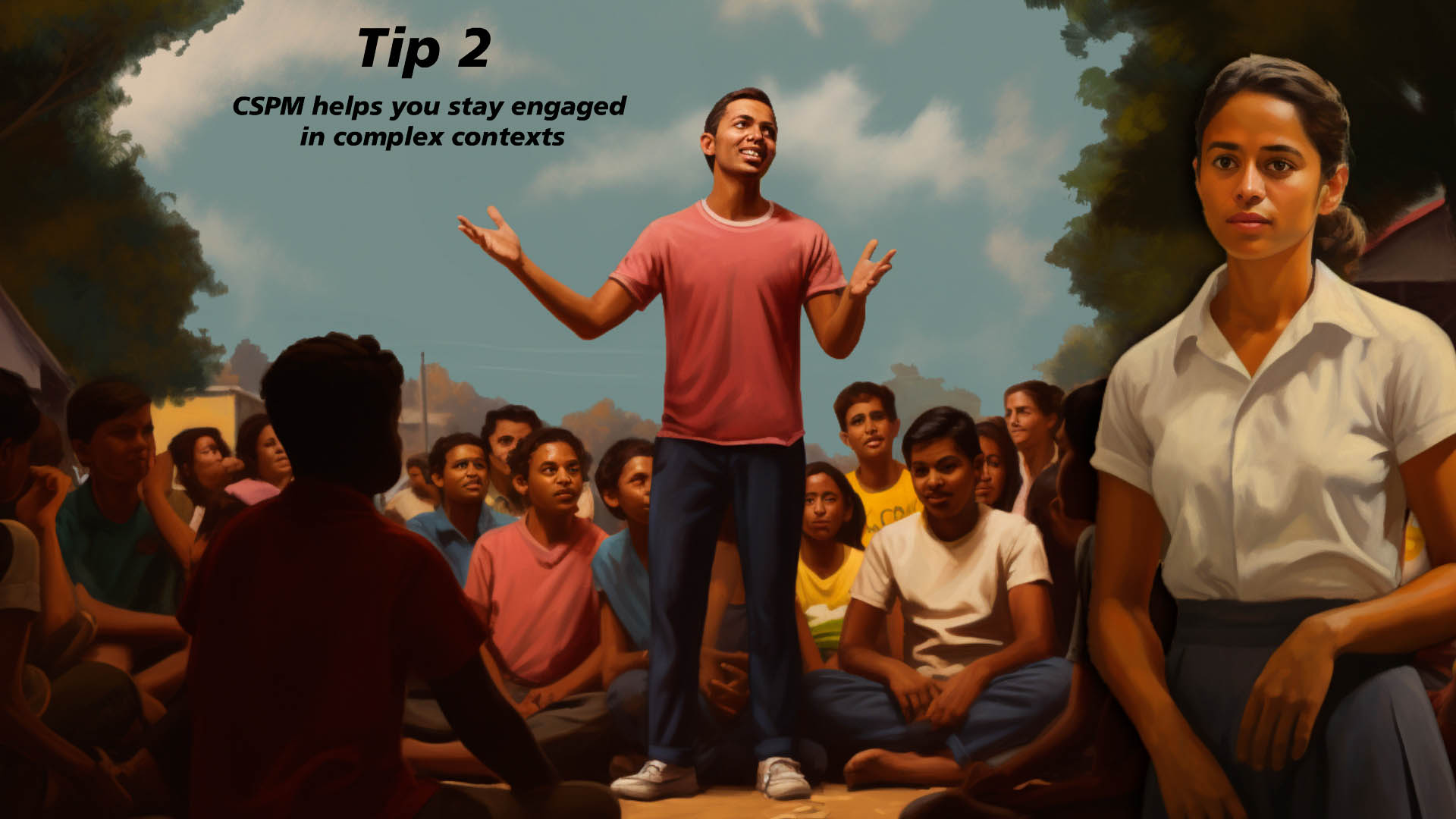

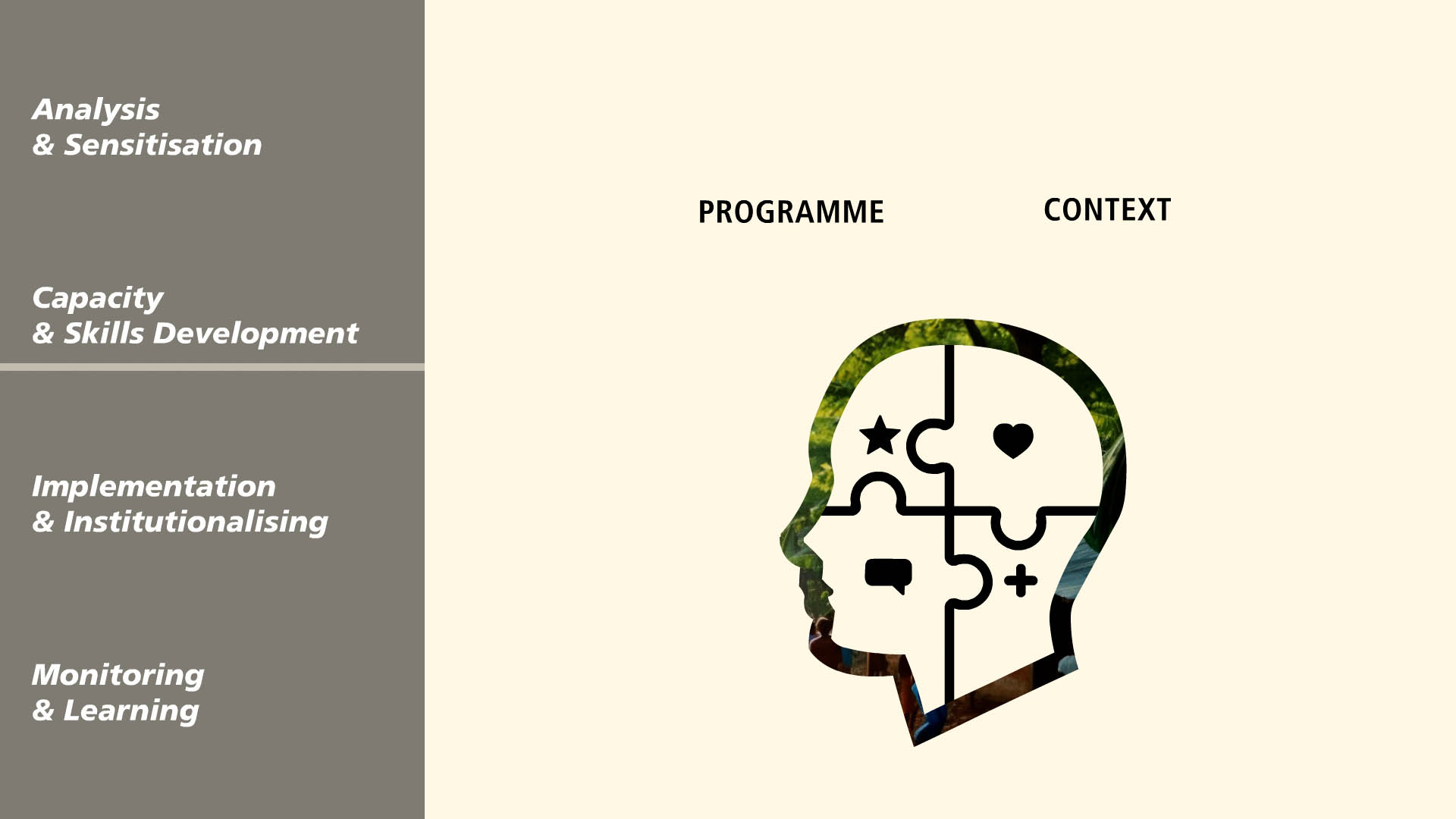

Wir haben 2 Animationen im gleichen Stil erstellt, jede mit ihrer eigenen Geschichte und Botschaft. Hier ein paar schöne Screenshots aus Video 02:

Lassen Sie mich mit dieser Weisheit schließen:

Es ist einfach, ein Bild mit AI zu erstellen.

Aber um das richtige Image zu schaffen

Lernen Sie weiter neue Fähigkeiten!